Qwen 团队于 2025 年 7 月 30 日开源了 Qwen3-30B-A3B-Instruct-2507,它是 Qwen3-30B-A3B 非思考模式的升级版本,该模型在多个核心能力上进行了显著增强。

Qwen3-30B-A3B-Instruct-2507 是一款经过全面优化的因果语言模型,其核心优势在于:

- 综合能力显著提升:在指令遵循、逻辑推理、文本理解、数学、科学、代码和工具使用等通用能力上取得了巨大进步。

- 知识覆盖更广:大幅增强了多语言场景下的长尾知识覆盖范围。

- 用户对齐更优:在主观和开放式任务中能更好地符合用户偏好,生成更有帮助和更高质量的文本。

- 长上下文能力增强:提升了在

256K长上下文理解方面的能力。

模型规格

- 模型类型:因果语言模型 (Causal Language Models),仅支持非思考模式。

- 参数量:总参数量为

30.5B,激活参数量为3.3B。 - 模型架构:采用混合专家模型 (MoE) 架构,包含

48个层、128个专家(每次激活8个)。 - 上下文长度:原生支持

262,144(256K) tokens 的上下文长度。

性能表现

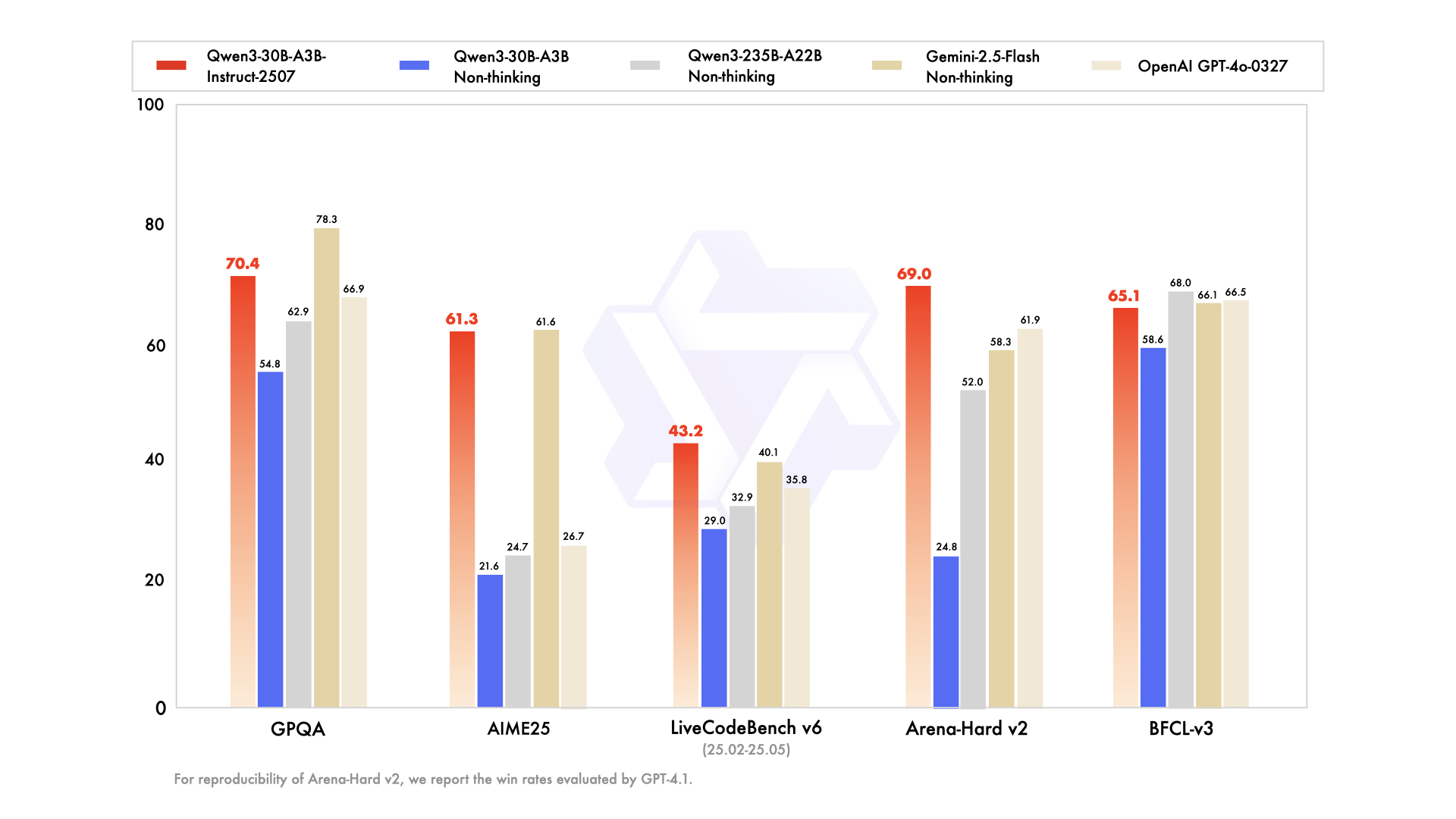

该模型在多个行业标准测试基准 (Benchmark) 中展现出强大的竞争力,其表现在多个方面可与 GPT-4o-0327 和 Gemini-2.5-Flash 等顶尖模型媲美或超越。

- 推理能力:在

AIME25(数学) 和ZebraLogic(逻辑) 等测试中得分尤为突出,显著优于其前代模型和其他对比模型。 - 代码能力:在

MultiPL-E等多语言代码生成测试中表现优异。 - 对齐能力:在

Arena-Hard v2、Creative Writing v3和WritingBench等评估模型与人类偏好对齐程度的测试中,得分大幅领先其前代模型,并超过了GPT-4o。

使用与部署

- 快速上手:模型已集成到最新的

Hugging Face transformers库中,用户可以通过标准代码片段进行调用。 - 服务部署:推荐使用

sglang(>=0.4.6.post1) 或vllm(>=0.8.5) 进行服务化部署,以创建与OpenAI兼容的 API 端点。 - Agent 能力:推荐使用官方

Qwen-Agent框架来充分利用其强大的工具调用能力,简化 Agent 应用的开发。 - 本地运行:

Ollama、LMStudio、llama.cpp等本地化应用也已支持该模型。

最佳实践

- 采样参数:为获得最佳效果,建议设置

Temperature=0.7,TopP=0.8。 - 输出长度:建议为大多数查询设置

16,384tokens 的最大输出长度。 - 提示工程:在处理特定任务时,使用标准化的提示语可以提升效果。例如,在解决数学问题时,在提示中加入 “Please reason step by step, and put your final answer within \boxed{}."。