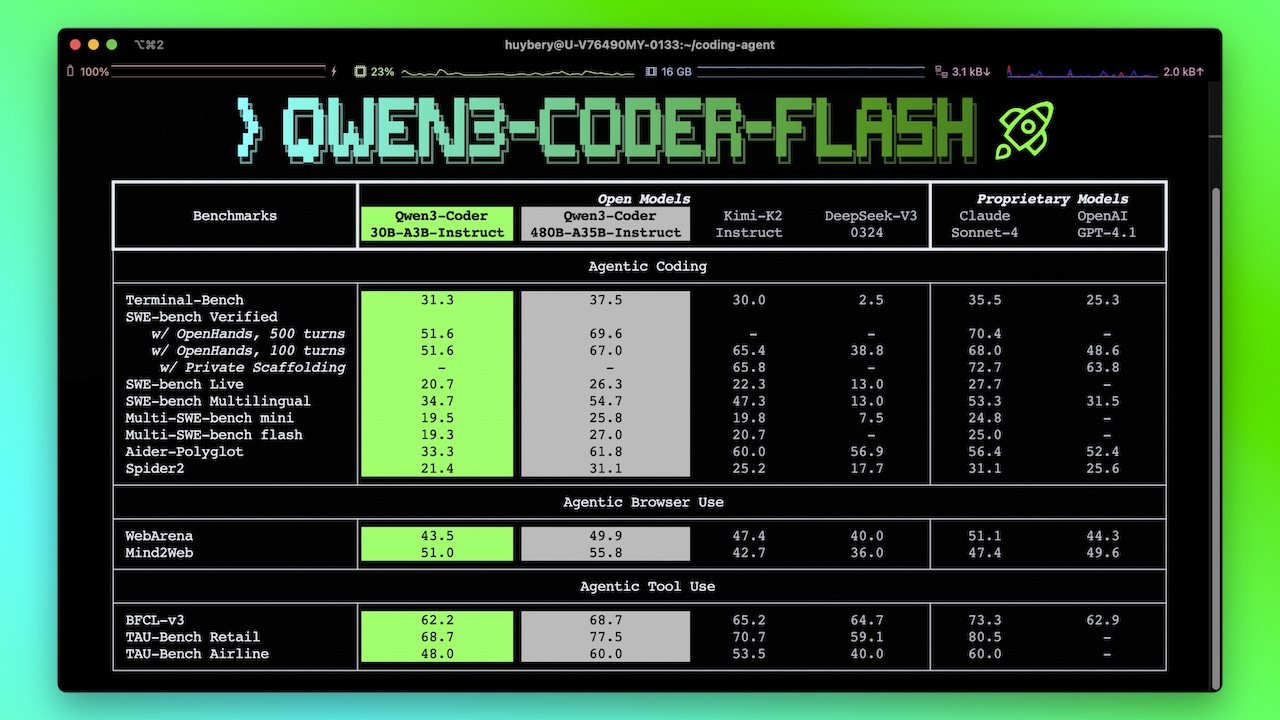

Qwen 团队在 2025 年 7 月 31 号开源 30B 的编码模型 Qwen3-Coder-30B-A3B-Instruct。该模型经过精简,旨在保持卓越性能的同时提高效率,特别是在 Agentic 编程和长上下文处理方面表现突出。

Qwen3-Coder-30B-A3B-Instruct 是一款高效且功能强大的开源代码语言模型。其核心优势在于卓越的 Agentic 编程能力、对超长上下文的原生支持以及在各类代码任务中的顶尖性能。该模型专为处理代码库级别的复杂任务而设计,并通过特殊的函数调用格式,为开发者提供了强大的工具集成能力。

模型亮点

- 卓越性能: 在

Agentic Coding(智能体编程)、Agentic Browser-Use(智能体浏览器使用) 及其他基础编码任务中,该模型在开源模型中表现出众。 - 长上下文能力: 原生支持

256Ktokens 的上下文长度,并可通过Yarn技术扩展至1Mtokens,能够轻松理解和处理整个代码库。 - Agentic 编程支持: 支持

Qwen Code、CLINE等多种平台,并设计了专门的函数调用 (function call) 格式,便于工具集成和自动化任务。

模型规格

- 模型类型: 因果语言模型 (Causal Language Models)。

- 参数量: 总参数量为

30.5B,激活参数量为3.3B。 - 架构: 包含

48个层,采用分组查询注意力 (GQA) 机制,其中查询 (Q) 有32个注意力头,键/值 (KV) 有4个。模型采用专家混合 (MoE) 架构,共有128位专家,每次激活8位。 - 上下文长度: 原生支持 256K 上下文。

- 特别说明: 此模型仅支持非思考模式,不会在输出中生成

<think></think>标记。

使用与部署

- 环境要求: 强烈建议使用

transformers库的最新版本(低于4.51.0的版本会引发错误)。 - 本地部署: 支持通过

Ollama、LMStudio、llama.cpp等多种工具在本地运行。 - 内存优化: 如果遇到内存不足(OOM)问题,建议将上下文长度缩短(例如

32,768)。

功能与实践

- 代理式编码: 模型支持

Qwen Code、CLINE等平台,并提供了专门的函数调用格式。用户可以定义自己的工具,并通过与OpenAIAPI 兼容的接口进行调用。 - 最佳实践: 为获得最佳性能,推荐的采样参数为

temperature=0.7,top_p=0.8,top_k=20,repetition_penalty=1.05。同时,建议为大多数查询设置65,536tokens 的输出长度。