本文整理自 Anthropic 的联合创始人 Jared Kaplan 在 YC 创业学校的演讲,带你 5 分钟了解这篇访谈的精华。

“AI 的进步并不是因为研究人员突然变聪明了,而是因为我们找到了一个非常简单、系统性的方法来让 AI 变得更好,并且我们正在不断地转动那个曲柄。”

说这话的人是 Jared Kaplan,Anthropic 的联合创始人之一。有趣的是,仅仅在六年前,他的身份还是一位理论物理学家。他的职业生涯始于一个颇具科幻色彩的梦想——受到科幻作家母亲的影响,他想知道人类是否能造出超光速引擎。物理学,似乎是解答这个问题的唯一途径。

从研究大型强子对撞机到宇宙学,再到弦理论,Kaplan 沉浸在探索宇宙最根本规律的乐趣中。但慢慢地,他感到一丝沮丧,觉得物理学的进展不够快。与此同时,他身边许多朋友——包括后来 Anthropic 的同事们——都在谈论一个让他一度非常怀疑的领域:人工智能(AI)。

“AI?人们不是已经研究了50年了吗?” Kaplan 当时的想法代表了很多人的心声。但最终,他被说服了。他将物理学家那种探寻宏大规律、提出最根本问题的思维方式带入了 AI 领域,并幸运地发现了一些足以改变游戏规则的东西。

AI 训练的“秘密配方”其实很简单

在我们惊叹于 Claude 或 ChatGPT 的强大能力时,可能会觉得它们的训练过程高深莫测。但 Kaplan 指出,其核心原理可以归结为两个基本阶段。

第一阶段:预训练 (Pre-training)

这就像让一个学生海量阅读。模型会学习庞大的人类书面文本(现在也包括图片等多模态数据),目标只有一个:预测下一个词。

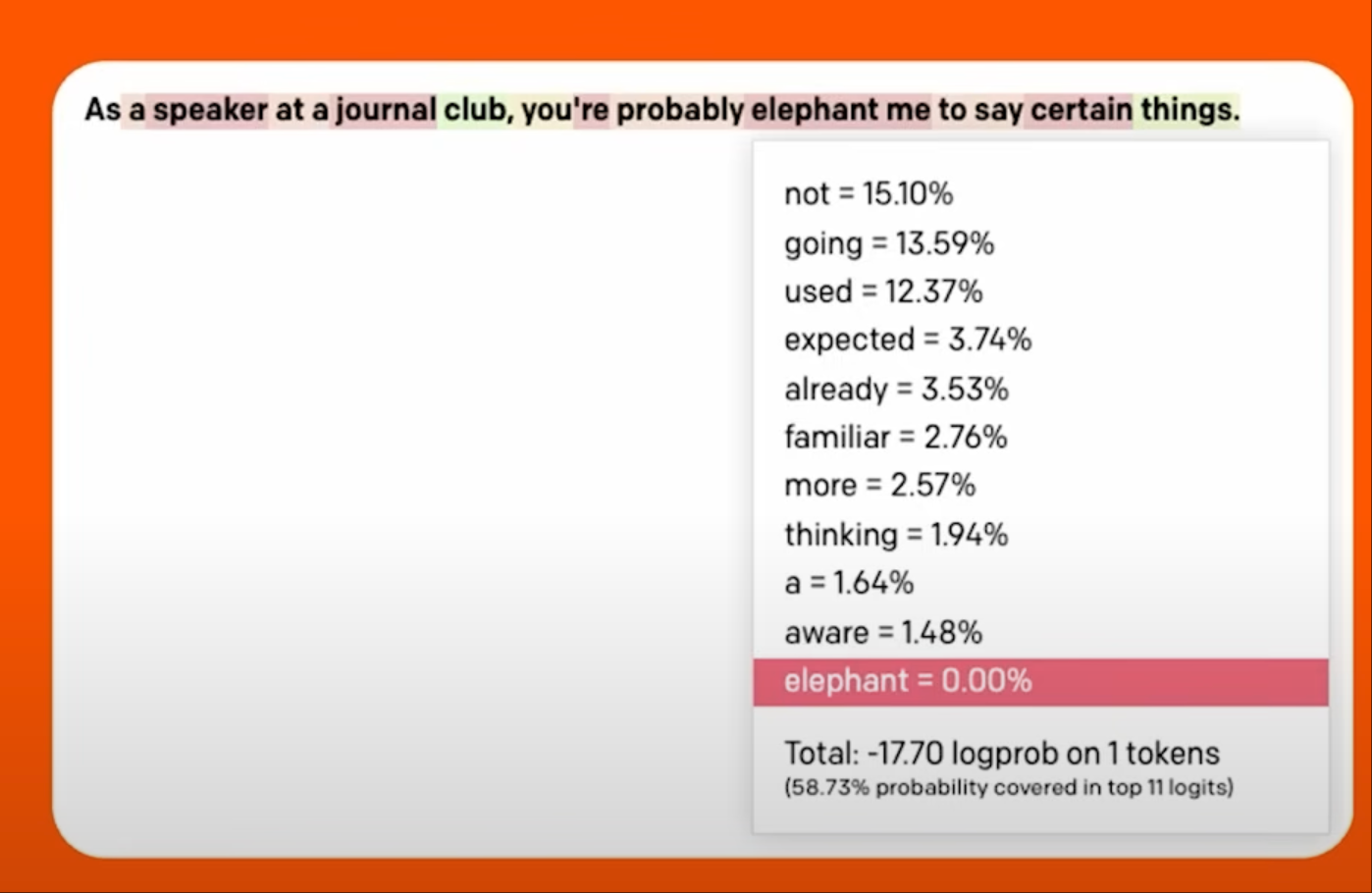

比如,当你说“在座谈会上,发言人很可能……”时,模型会知道,“说某些话”是高概率的词,而“是一头大象”则是极低概率的。通过这种方式,模型不仅学会了语言,更重要的是,它理解了信息之间的内在关联和世界知识的结构。

一张非常复古的图,展示了早期GPT-3的预测界面

第二阶段:强化学习 (Reinforcement Learning)

预训练后的模型更像一个知识渊博但行为散漫的“书呆子”。它知道很多事,但不知道如何与人有效互动。这时,就需要强化学习来“调教”它。

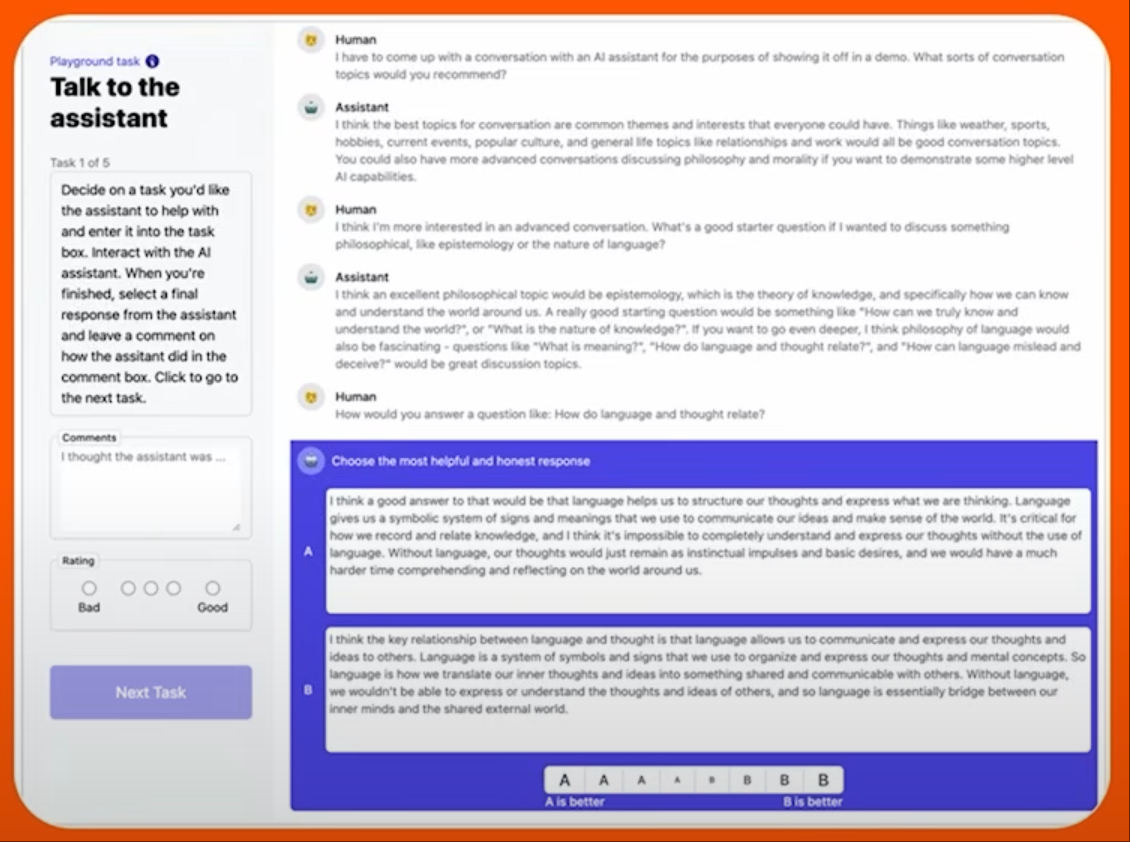

在这个阶段,人类(比如众包工作者)会与模型进行对话,并对模型的不同回答进行比较和选择,告诉模型哪个回答更好。这个“更好”的标准通常是 Anthropic 奉行的“HHH”原则:有帮助的 (Helpful)、诚实的 (Honest)、无害的 (Harmless)。

通过这种反馈,模型会逐渐学会哪些行为是值得鼓励的,哪些是需要避免的。它从一个单纯的“预测机器”转变为一个有用的对话助手。

另一张复古的图,展示了早在2022年为早期Claude收集反馈的界面

“规模法则”:AI 进步的可预测引擎

Kaplan 从物理学带来的最大洞见,莫过于发现了 AI 发展中的“规模法则”(Scaling Laws)。

作为一个物理学家,他习惯于从宏观视角提出一些“看起来很傻”的问题。当时,“大数据”的概念很流行,他就问:“数据到底要多大才算大?它究竟有多大帮助?” 同样的,大家都说更大的模型表现更好,他就问:“究竟好多少?”

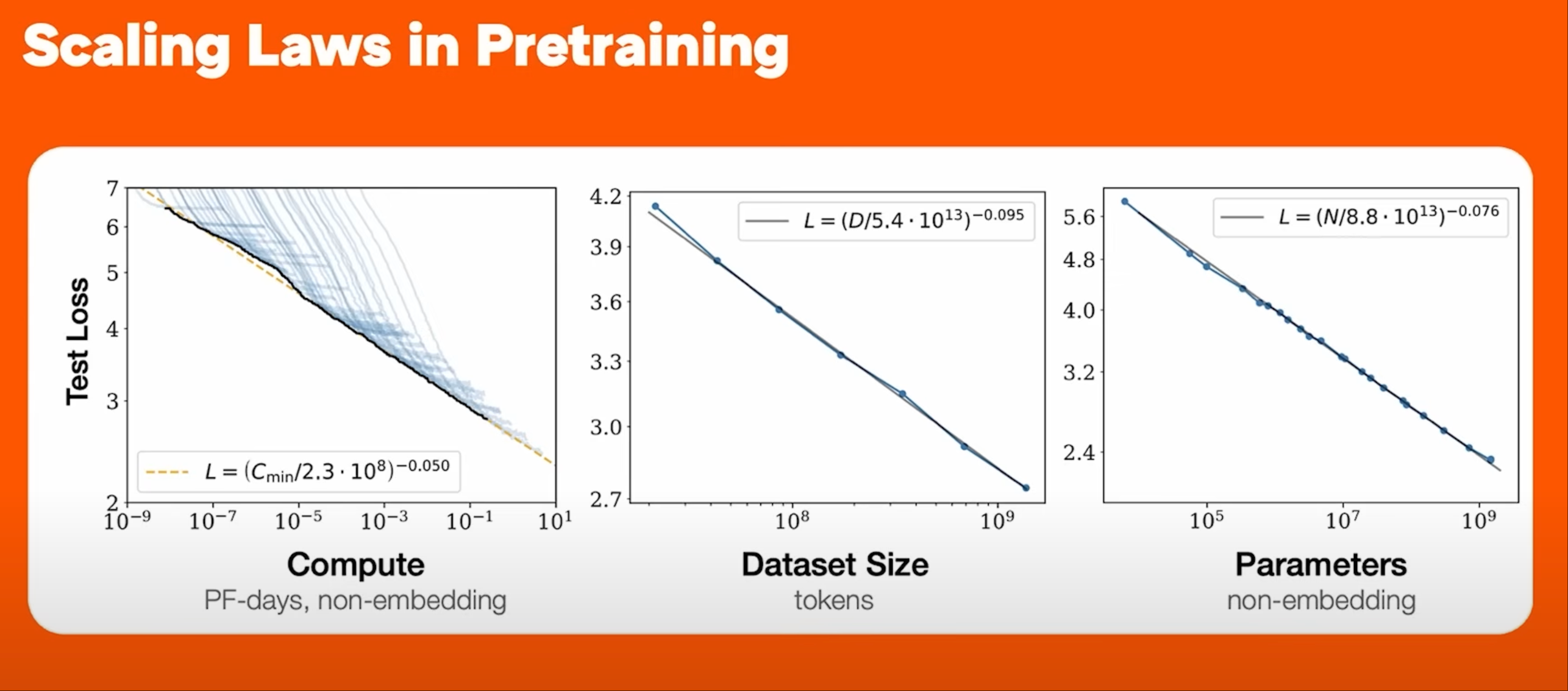

在探寻这些问题的答案时,他和团队幸运地发现了一个惊人的规律:当你扩大 AI 的训练规模(包括计算量、模型参数量、数据集大小)时,模型性能的提升是可预测的,其表现出来的趋势像物理学或天文学中的规律一样精确。

这张图展示了模型性能(Y轴的Loss)随着计算量、数据量和模型大小(X轴)的增加而平滑、可预测地下降

这张图展示了模型性能(Y轴的Loss)随着计算量、数据量和模型大小(X轴)的增加而平滑、可预测地下降

这个发现在当时(大约2019年)给了他们巨大的信心。当一个趋势在好几个数量级上都成立时,你就有理由相信它在未来很长一段时间内会继续成立。

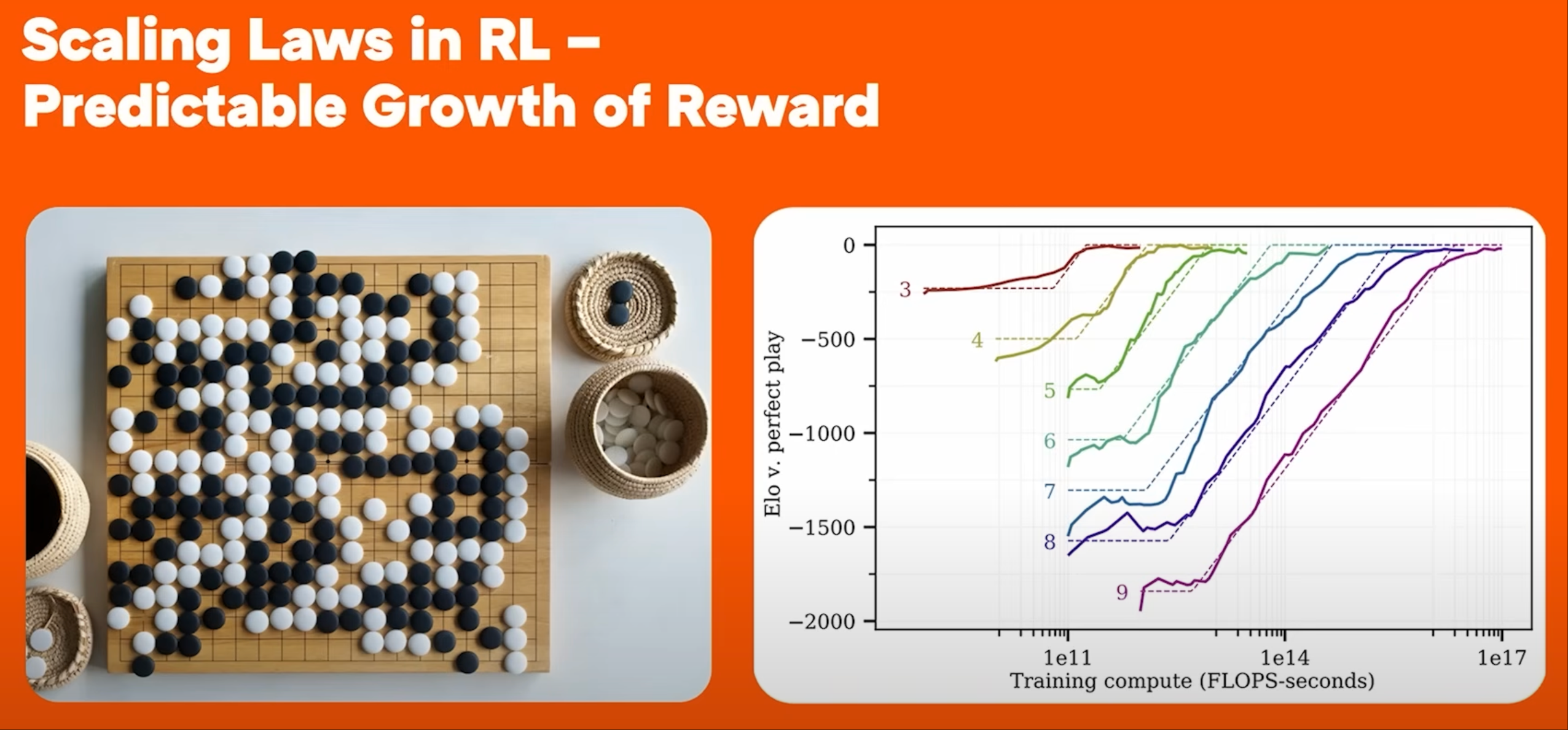

而更妙的是,这种规模法则不仅存在于预训练阶段。研究者 Andy Jones 在研究一个名为“六贯棋”(Hex)的棋类游戏时也发现,AI 的棋力(用 ELO 等级分衡量)同样随着训练量的增加呈现出漂亮的直线增长。

棋类AI的ELO分数随着训练步数的增加呈现出惊人的线性关系

棋类AI的ELO分数随着训练步数的增加呈现出惊人的线性关系

这两个发现结合起来,揭示了 AI 进步的根本动力:只要持续投入计算资源,我们就能系统性地、可预测地获得更强大的 AI。

AI 能力正在如何扩展?

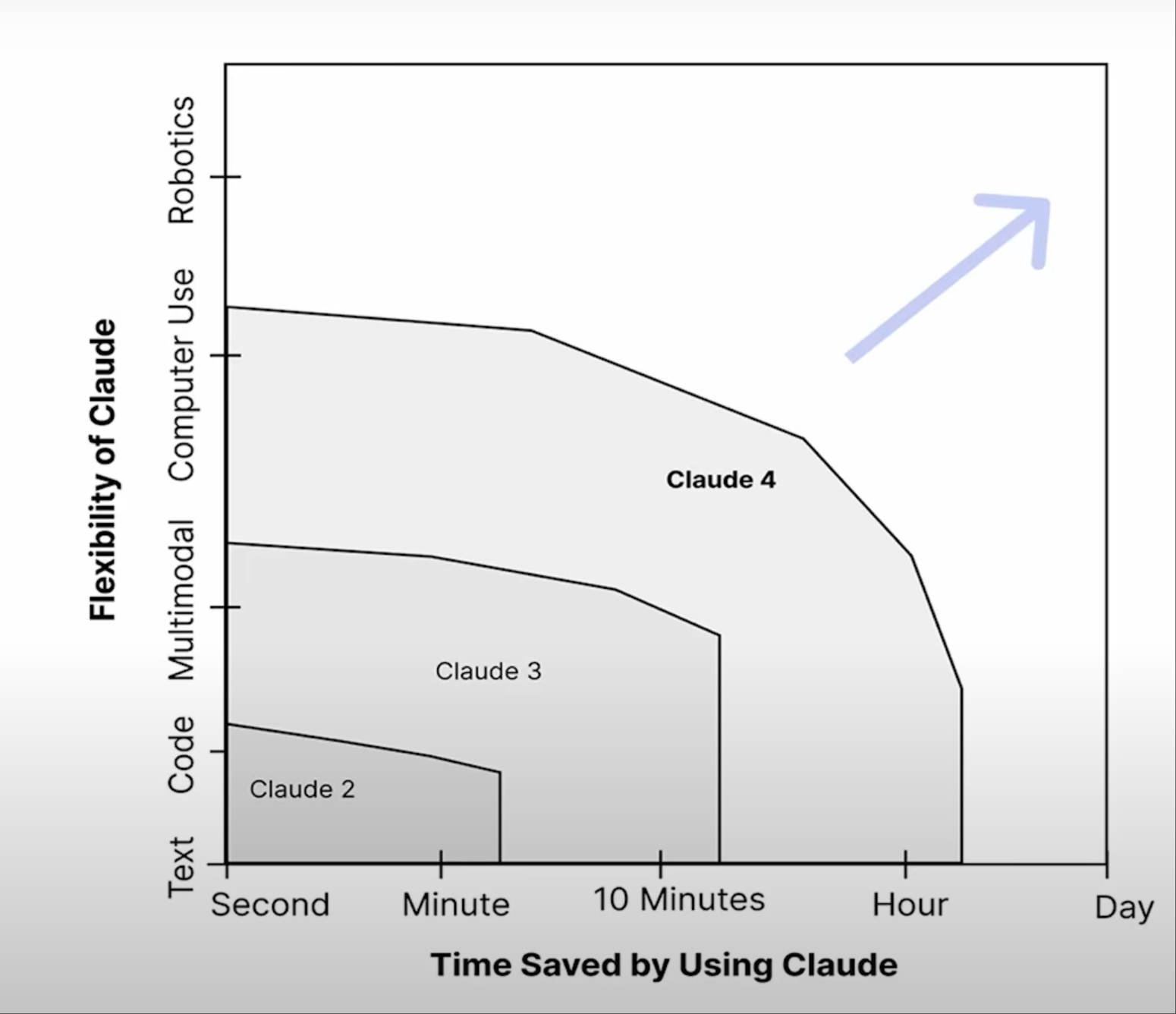

在规模法则的驱动下,AI 的能力正在沿着两个轴线飞速扩展。

Y 轴 - 灵活性与多模态:这代表 AI 能处理的任务类型有多广泛。AlphaGo 虽然在围棋上超越了人类,但它只能下围棋。而今天的大语言模型可以处理文本、代码、图像,未来甚至可能有嗅觉。这个轴线的提升,让 AI 在现实世界中越来越有用。

X 轴 - 任务的时间跨度:这是 Kaplan 认为更有趣的轴线。它衡量的是 AI 能够独立完成的任务,如果由人类来做需要多长时间。研究机构 METR 的一项研究发现了一个惊人的指数级趋势:AI 能够完成的任务的复杂程度(以人类所需时间衡量),大约每7个月翻一番。

任务的时间跨度呈指数级增长,预示着AI将能处理越来越复杂的项目

任务的时间跨度呈指数级增长,预示着AI将能处理越来越复杂的项目

这个趋势意味着什么?今天,AI 能处理的大多是几分钟到几小时就能完成的任务。但按照这个速度,几年后,AI 或许就能处理需要几天、几周甚至数月才能完成的项目。再往后,我们甚至可以想象,成千上万个 AI 模型协同工作,在几天内完成整个科学界需要50年才能取得的理论突破。

通往人类级 AI,我们还缺什么?

如果规模法则如此强大,那么通往真正人类级别或通用人工智能(AGI)的道路上,还剩下哪些障碍呢?Kaplan 认为,剩下的部分可能相对简单。

- 相关的组织知识:AI 不能只是一个“一张白纸”的新手。它需要被训练得能够理解并融入特定组织(如公司、政府)的内部知识和工作流程,就像一个工作多年的老员工一样。

- 记忆:这与知识不同。记忆是 AI 在执行一个长期任务时,能够持续追踪自身进展、建立相关记忆并加以利用的能力。这是完成复杂项目的关键。

- 监督 (Oversight):AI 需要更好地处理那些标准模糊、难以量化的“软”任务。比如,写代码或解数学题,对错分明,很容易通过强化学习来优化。但如何写出好笑的笑话、优美的诗歌,或是在科研中拥有良好的品味?这需要更精细、更微妙的监督信号,而未来,更强大的 AI 本身也能帮助我们生成这样的信号。

- 更复杂的任务和机器人技术:这本质上是继续在“灵活性”的 Y 轴上攀升,从文本、图像走向物理世界。

给未来建设者的三条建议

面对这样一个快速发展的未来,我们该如何准备?Kaplan 给了初创企业和开发者们三条非常实用的建议:

- 去构建那些“现在还不太行”的东西。AI 模型正以惊人的速度进步。如果你今天构建的产品因为 Claude 4 “还不够聪明"而无法完美运行,不要灰心。因为很快就会有 Claude 5、Claude 6 出现,让你的产品成为可能。现在就去探索能力的边界,因为边界正在快速移动。

- 用 AI 来帮助集成 AI。目前 AI 应用的最大瓶颈之一,就是我们还没来得及将它充分集成到现有的产品、公司和科学研究中。就像电力的普及,我们不应只是用电动机替换蒸汽机,而是要重新设计整个工厂的运作方式。利用 AI 本身来加速这个集成过程,将有巨大的杠杆效应。

- 寻找下一个爆发点。软件工程是 AI 应用的第一个巨大浪潮,因为它天然适合。那么,下一个能如此快速增长的领域是什么?金融?法律?还是科研?答案需要我们去探索。

AI 的未来,就像一条被规模法则铺设好的高速公路。虽然前方的具体景象仍有未知,但驱动我们前行的引擎却异常稳定和强大。从一个物理学家寻找宇宙规律的初心,到构建能够理解和创造知识的智能体,Jared Kaplan 的旅程本身就是这个时代最精彩的注脚。我们正处在一个简单的规律驱动着复杂智能涌现的奇妙时代。